[카테고리:] AI

-

Supermemory: LLM을 위한 Universal Memory Layer

AI 시대에 가장 큰 과제 중 하나는 바로 ‘기억(Memory)’입니다. 대부분의 LLM은 대화가 끝나면 모든 컨텍스트를 잊어버리고, 다음 세션에서는 마치 처음 만난 사람처럼 행동합니다. 이러한 문제를 해결하기 위해 등장한 것이 바로 Supermemory입니다. Supermemory란? Supermemory는 19세 창업자 Dhravya Shah가 개발한 AI 애플리케이션을 위한 범용 메모리 레이어입니다. 2025년 10월 Google AI 총괄 Jeff Dean, Cloudflare CTO Dane Knecht,…

-

AI에게 기억을 준다는 것

AI에게 장기 메모리(Long-Term Memory)가 생긴다는 것은 단순한 ‘기능 추가’를 넘어, AI가 ‘단발성 도구’에서 ‘지속적인 파트너’로 진화한다는 것을 의미합니다. 현재 대부분의 LLM(대규모 언어 모델)은 대화창을 닫거나 일정 분량(컨텍스트 윈도우)이 넘어가면 이전 내용을 잊어버리는 ‘휘발성’을 가지고 있습니다. 장기 메모리는 이 한계를 극복하는 핵심 열쇠입니다. 모델은 과거의 상호작용, 사용자의 선호, 행동 패턴 등을 저장하고, 이를 기반으로 새로운 환경이나,…

-

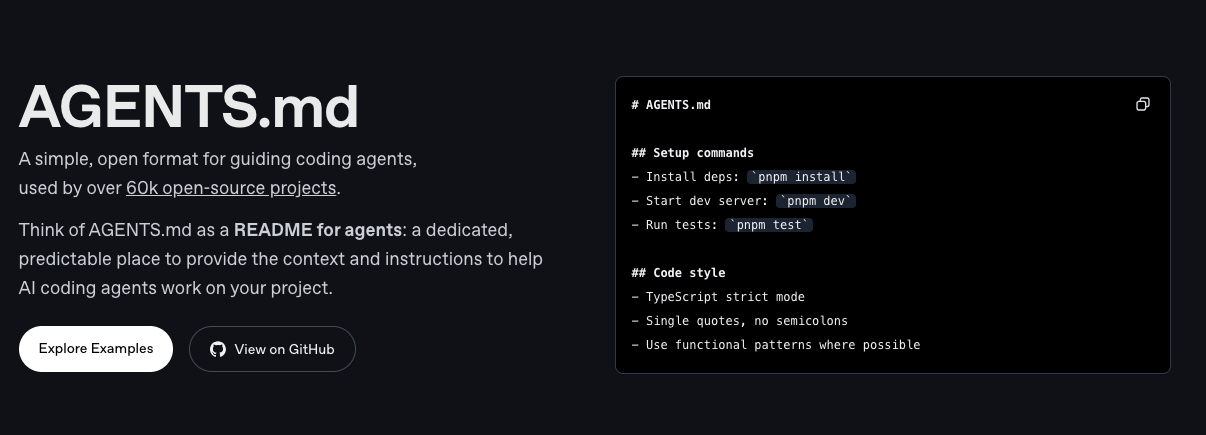

AGENTS.md: AI 시대의 프로젝트 문서화 혁신

들어가며 AI와 함께 코딩하는 시대가 본격적으로 도래했습니다. GitHub Copilot, Cursor, Claude Code 등 다양한 AI 코딩 어시스턴트들이 개발자의 일상에 깊숙이 자리 잡으면서, 우리는 “바이브 코딩(Vibe Coding)”이라는 새로운 개발 패러다임을 경험하고 있습니다. 하지만 AI 에이전트가 우리의 프로젝트를 제대로 이해하고 효과적으로 기여하려면 무엇이 필요할까요? 바로 이 지점에서 AGENTS.md가 등장합니다. OpenAI, Google, Factory.ai, Cursor 등이 협력하여 만든 이…

-

Antigravity: AI 에이전트 시대를 여는 새로운 개발 플랫폼

들어가며 2025년 11월 18일, Google DeepMind는 Gemini 3 모델 출시와 함께 개발자들을 위한 혁신적인 도구를 공개했습니다. 바로 Google Antigravity입니다. “반중력”이라는 이름처럼, 이 도구는 무거운 코딩 작업의 중력에서 개발자를 해방시키겠다는 야심찬 목표를 가지고 있습니다. Antigravity는 단순한 AI 코딩 어시스턴트가 아닙니다. 에이전트가 계획을 수립하고, 실행하고, 에디터, 터미널, 브라우저를 통해 복잡한 작업을 검증할 수 있도록 하는 “에이전트 우선(Agent-first)”…

-

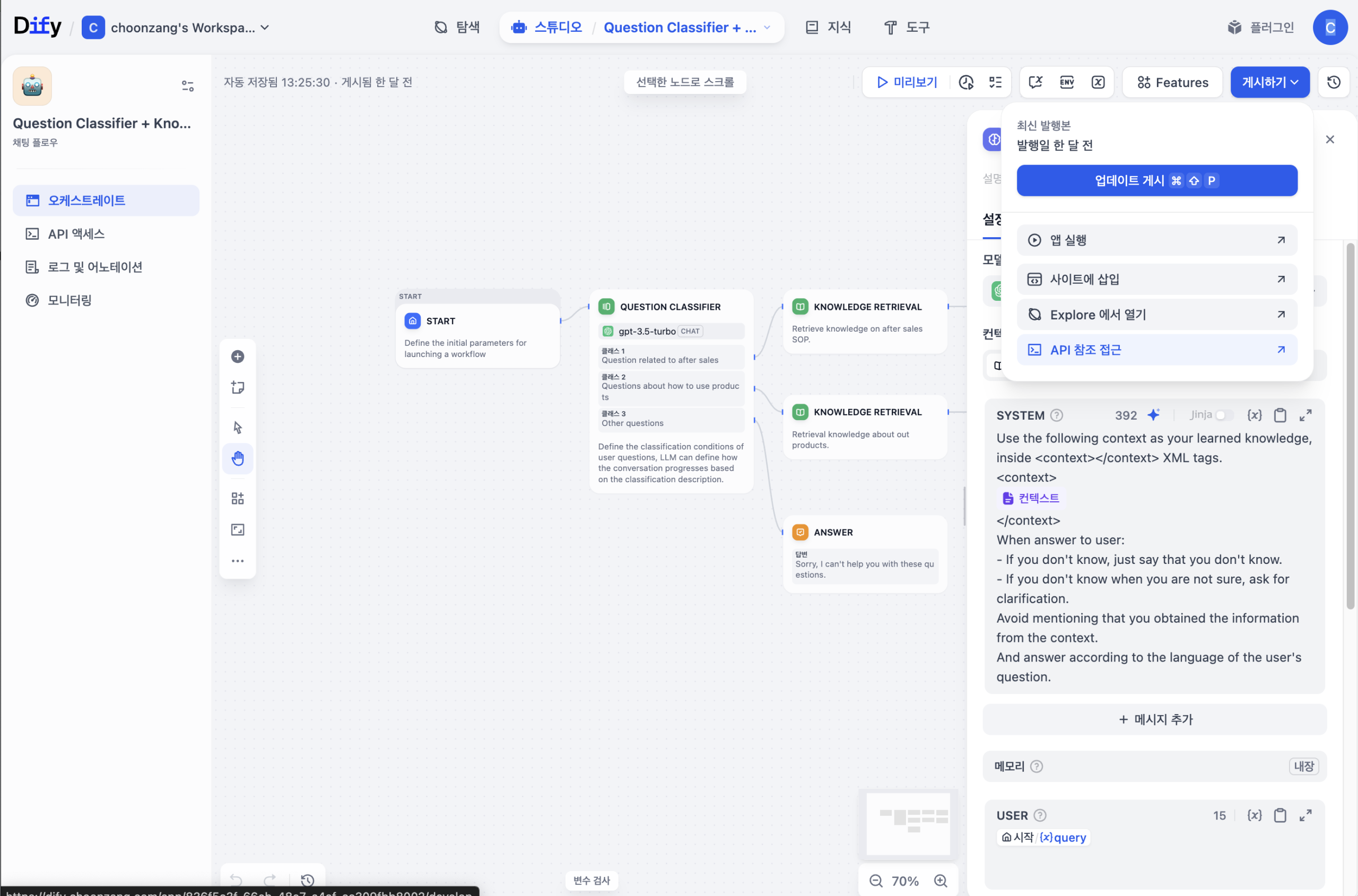

AI 애플리케이션 개발을 위한 추천 플랫폼, Dify AI Platform

Dify란? 앞서 다양한 Agent를 사용한 Workflow도구들이 많이 소개했었는데요. 이번에 매우 직관적이고, 간단하게 AI 어플리케이션 개발에 필요한 백엔드 도구가 있어서 소개하려고 합니다. 바로 Dify 인데요. Dify는 프로덕션 수준의 AI 에이전트 워크플로우를 구축하기 위한 오픈소스 플랫폼입니다. 이름 Dify는 “Do It For You”의 약자로, 복잡한 AI 애플리케이션 개발 과정을 단순화하고 자동화하겠다는 플랫폼의 철학을 담고 있습니다. 공식출시는 2023년 5월9일입니다.…

-

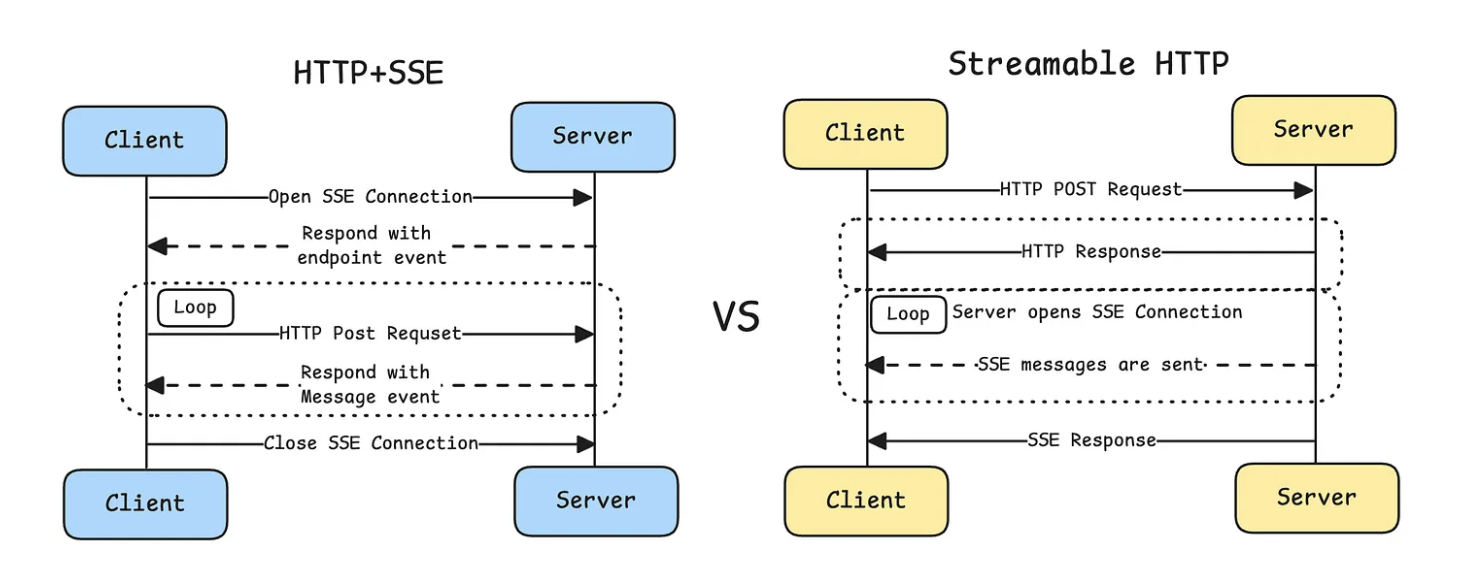

MCP 전송 프로토콜 변경: HTTP+SSE에서 Streamable HTTP로

들어가며 2024년 11월 Anthropic이 발표한 Model Context Protocol(MCP)은 AI 애플리케이션과 다양한 데이터 소스를 연결하는 표준 프로토콜로 빠르게 자리잡았습니다. 하지만 2025년 3월, MCP는 전송 메커니즘에 있어 중대한 변경을 단행했습니다. 바로 HTTP+SSE 방식에서 Streamable HTTP로의 전환입니다. 이 글에서는 왜 이러한 변경이 필요했는지, 그리고 두 방식이 어떻게 다른지 살펴보겠습니다. MCP와 JSON-RPC 2.0 먼저 MCP의 기본 통신 방식을 이해해야…

-

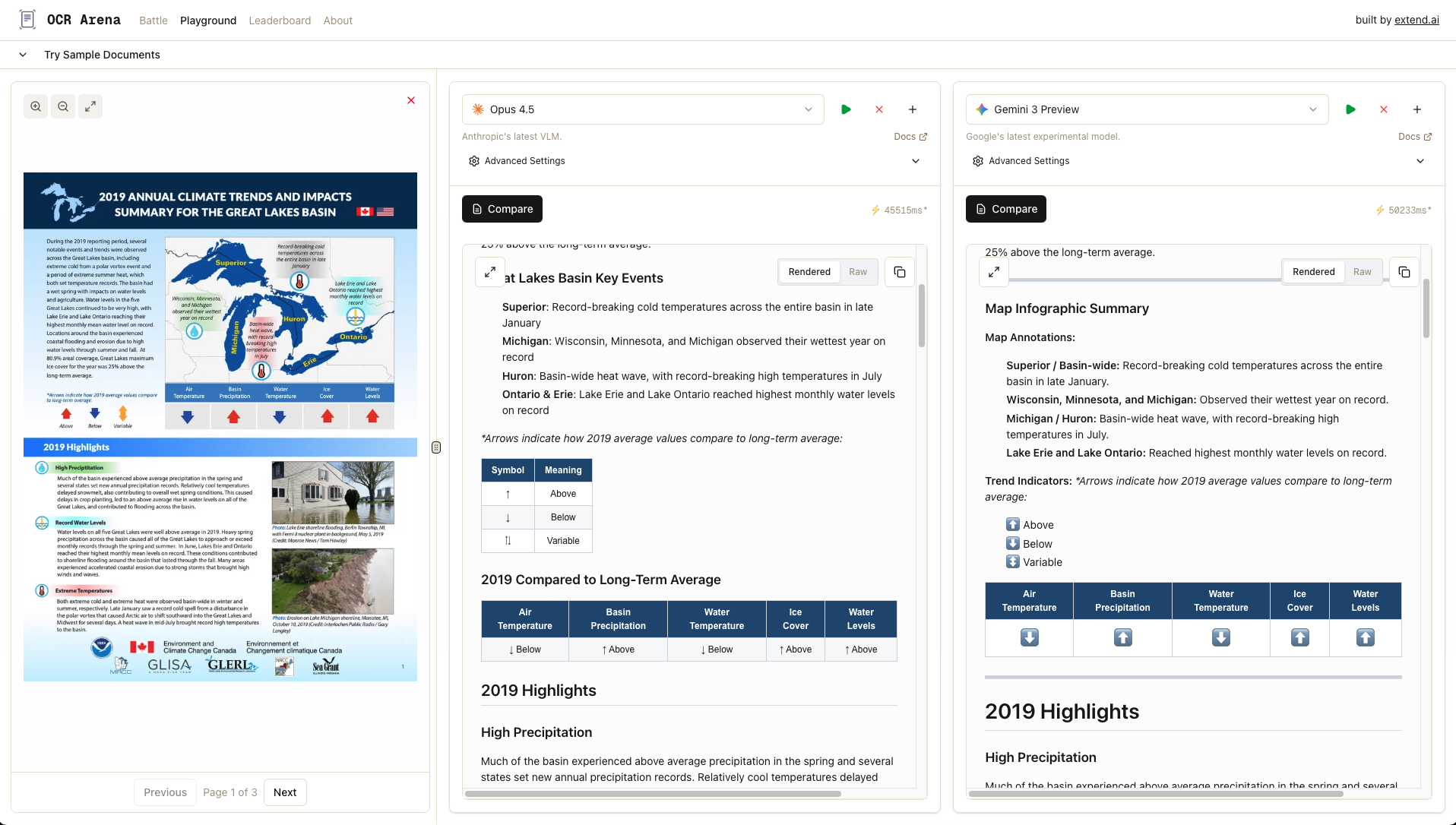

OCR Arena, OCR 테스트를 직접해보세요.

OCR Arena는 문서 파싱 작업에서 주요 기반 VLM과 오픈소스 OCR 모델을 테스트하고 평가할 수 있는 무료 플랫폼입니다. 문서를 업로드하고 정확도를 측정한 후, 공개 리더보드에서 최고의 모델에 투표할 수 있습니다. OCR Arena는 Extend 팀에서 개발했습니다 . Baseten의 지원을 받아 10개 이상의 모델을 출시했으며, 앞으로도 지속적으로 새로운 모델이 출시되면 추가될 예정이라고 하네요. . 문서 처리는 AI 애플리케이션…

-

구글 Gemini 3 Pro 런칭: 바이브 코딩의 새로운 시대

구글이 AI 개발의 판도를 바꿀 Gemini 3 Pro를 공개했습니다. 이번 출시는 단순한 성능 업그레이드가 아닌, 개발 방식 자체를 근본적으로 재편하는 혁신입니다. 특히 “바이브 코딩(Vibe Coding)”이라는 새로운 개발 패러다임에 편승하며, 개발자와 AI의 관계를 완전히 새롭게 정의하고 있습니다. Gemini 2.5 Pro vs Gemini 3 Pro: 무엇이 달라졌나? 1. 압도적인 벤치마크 성능 향상 Gemini 3 Pro는 2.5 Pro…

-

![[GPU 자원 관리 방법] MIG vs CUDA_VISIBLE_DEVICES: 완벽한 격리? 유연한 공유?](https://blog.choonzang.com/wp-content/uploads/2025/11/Generated-Image-November-19-2025-11_28PM.png)

[GPU 자원 관리 방법] MIG vs CUDA_VISIBLE_DEVICES: 완벽한 격리? 유연한 공유?

이번에 GPU 정부지원 사업을 신청하여 H100 4장을 할당 받았습니다. 각 본부에서 LLM 개발 및 fine tuning을 목적으로 할당 하여 사용할 계획입니다. 아무래도 지원 사업 자체가 하나의 인스턴스에 GPU 자원을 나눠서 사용해야 하는 방식이다보니 자원을 어떻게 할당하는 것이 좋을지 알아보다가 정리된 내용을 포스트로 기록합니다. GPU 자원을 관리하는 가장 대표적인 두 가지 방식, NVIDIA MIG(Multi-Instance GPU)와 CUDA_VISIBLE_DEVICES…