지난 8월 OpenAI가 GPT5를 공개하였습니다. 오픈 이후에 매우 다양한 의견들이 있었는데요. . 질의의 내용에 따라 적절한 수준의 모델을 선정하여 효율성을 높이는 모델 라우팅에 대한 이슈가 매우 뜨거웠습니다. 다만, 비용을 효과적으로 관리하는 측면에서의 LLM의 라우팅은 필수적인 선택으로 갈것으로 보입니다. 또는 더 좋은 응답을 생성하기위한 필수적인 아키텍처일수 있다고도 생각됩니다.

vLLM Semantic Router가 이러한 AI 모델 라우팅에 대한 서비스를 제공해주는 솔루션이 되겠습니다.

기존 단일 모델 배포의 한계와 문제점

경제적 비효율성: 과도한 비용 부담

기존의 단일 모델 접근법은 심각한 경제적 비효율성을 초래합니다. 실제 사례를 살펴보겠습니다.

고객 지원 챗봇 예시:

- 간단한 FAQ: “영업시간이 어떻게 되나요?”

- GPT-4 사용 시: 50토큰 응답에 $0.0015 비용

- 월 10만 개의 간단한 질의 = $150 (실제로는 $0.001 모델로도 충분)

- 잠재적 절약: 95% 이상

이는 마치 동네 슈퍼에서 우유를 사러 가는데 롤스로이스를 타고 가는 것과 같은 상황입니다.

성능 최적화의 한계

각각의 작업에는 최적화된 전문 모델이 존재합니다:

- 수학 문제 “2x + 5 = 15 풀어줘”

- 범용 GPT-4: 좋은 성능이지만 과도한 리소스 사용

- 수학 전문 모델: 더 빠르고, 정확하며, 저렴함

- 창작 글쓰기 “봄에 관한 시를 써줘”

- 수학 최적화 모델: 창의성 부족

- 범용 모델: 무난하지만 특화되지 않음

- 창작 특화 모델: 뛰어난 문체적 품질

리소스 낭비와 운영 리스크

- 컴퓨팅 파워: 단순 분류에 1.8조 파라미터 모델 사용

- 메모리: 가벼운 작업에 대형 모델 로딩

- 지연시간: 빠르게 처리될 수 있는 작업의 느린 추론

- 단일 장애점: 모델 다운타임이 전체 시스템에 영향

Mixture-of-Models: 지능형 솔루션

혁신적 비용 최적화

MoM은 복잡성과 작업 유형에 따라 쿼리를 지능적으로 라우팅합니다:

# 기존 접근법

전통적_비용 = 100,000 * 0.03 # 모든 쿼리를 GPT-4로

# 결과: $3,000.00

# MoM 접근법

mom_비용 = (70,000 * 0.002) + # 간단한 것은 GPT-3.5로

(20,000 * 0.01) + # 중간은 Claude로

(10,000 * 0.03) # 복잡한 것만 GPT-4로

# 결과: $640.00

# 절약: 78.7%

전문화를 통한 성능 향상

| 작업 카테고리 | 전문 모델 | 성능 향상 | 비용 절감 |

|---|---|---|---|

| 수학적 추론 | Math-fine-tuned BERT | +25% 정확도 | 90% 절약 |

| 코드 생성 | CodeLlama/GitHub Copilot | +40% 코드 품질 | 60% 절약 |

| 창작 글쓰기 | Creative-fine-tuned GPT | +30% 창의성 점수 | 70% 절약 |

| 간단한 Q&A | 경량 모델 | 유사한 정확도 | 95% 절약 |

| 복잡한 분석 | 프리미엄 모델 | 품질 유지 | 필요시에만 사용 |

실제 성공 사례들

사례 1: 대형 온라인 쇼핑몰 고객 서비스

현황: 일일 5만 건의 고객 문의 처리 과제: 고객 만족과 운영 비용의 균형

MoM 도입 전:

- 설정: 모든 고객 서비스 쿼리에 GPT-4 사용

- 일일 비용: $4,500

- 성능: 우수하지만 간단한 쿼리에는 과도한 비용

MoM 도입 후 결과:

- 비용 절감: 72% ($4,500 → $1,260/일)

- 고객 만족도: +12% (전문화된 모델의 우수한 성능)

- 응답 시간: 평균 지연시간 35% 단축

- 확장성: 동일 인프라로 40% 더 많은 쿼리 처리

사례 2: 교육 기술 플랫폼

현황: 일일 10만 건의 학생 질문 처리 과제: 다양한 과목에 대한 개인화된 학습 지원

전문 모델 배포 결과:

subject_routing = {

"수학": {

"모델": "math-specialized-llama",

"일일_쿼리": 35000,

"쿼리당_비용": 0.002,

"정확도": 96.5,

"학생_만족도": 4.7

},

"과학": {

"모델": "science-domain-bert",

"일일_쿼리": 25000,

"쿼리당_비용": 0.0015,

"정확도": 94.8,

"학생_만족도": 4.5

}

# ... 기타 과목들

}

교육적 임팩트:

- 비용 효율성: $3,000/일 → $890/일 (70% 절감)

- 학습 성과: 문제해결 점수 23% 향상

- 개인화: 과목별 전문 지원 향상

- 접근성: 동일 예산으로 3배 더 많은 학생 서비스 가능

VLLM Semantic Router의 핵심 기술적 특징

지능형 의미론적 라우팅

BERT 기반의 의미론적 이해를 통해 다음과 같이 자동으로 모델을 선택합니다:

- 수학 문제 → 수학 전문화 모델

- 창작 요청 → 창의성 특화 모델

- 코드 생성 → 프로그래밍 전문 모델

- 일반 질의 → 균형잡힌 범용 모델

강화된 보안 및 개인정보 보호

- PII 탐지: 개인식별정보 자동 감지 및 적절한 처리

- 프롬프트 가드: 탈옥 시도(Jailbreak) 식별 및 차단

- 안전한 라우팅: 민감한 프롬프트의 적절한 처리 보장

성능 최적화 기능

- 의미론적 캐시: 의미적 표현 캐싱으로 지연시간 단축

- 도구 자동 선택: 관련 도구만 선택해 토큰 사용량 감소 및 정확도 향상

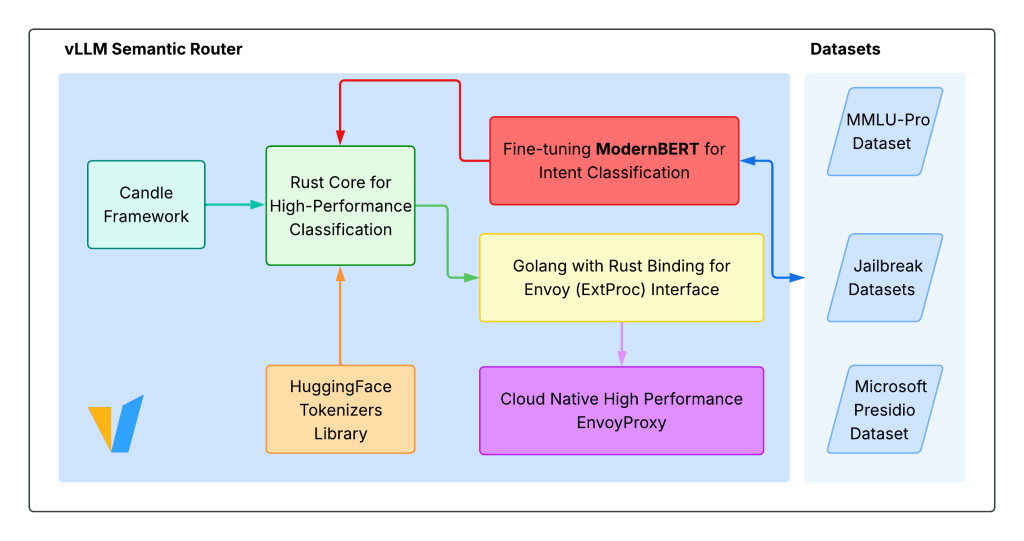

프로덕션 준비된 아키텍처

- Envoy ExtProc 통합: 기존 인프라와의 원활한 연동

- 이중 구현: Go(Rust FFI 포함)와 Python 버전 제공

- 확장 가능한 설계: 포괄적인 모니터링과 함께 프로덕션 환경 지원

모니터링과 관찰 가능성

포괄적인 모니터링 시스템

- Grafana 대시보드: 실시간 메트릭과 성능 추적

- Prometheus 메트릭: 상세한 라우팅 통계와 성능 데이터

- 요청 추적: 라우팅 결정과 성능에 대한 완전한 가시성

경제적 임팩트 분석

12개월 비용 비교 (월 100만 쿼리 조직 기준)

# 단일 모델 비용

단일_모델_비용 = {

"모델_사용": 12 * 1000000 * 0.03, # $360,000

"인프라": 12 * 5000, # $60,000

"유지보수": 12 * 2000, # $24,000

"총합": 444000

}

# MoM 비용

mom_비용 = {

"라우터_개발": 50000, # 일회성

"모델_사용": 12 * 1000000 * 0.012, # $144,000 (60% 절감)

"인프라": 12 * 3500, # $42,000 (분산 부하)

"유지보수": 12 * 2500, # $30,000

"라우터_운영": 12 * 1000, # $12,000

"총합": 279000

}

절약액 = 444000 - 279000 # $165,000

ROI_달성_월수 = 50000 / (165000 / 12) # 3.6개월

결과:

- 12개월 절약액: $165,000

- ROI 달성: 3.6개월

실제 활용 시나리오

1. 기업 API 게이트웨이

다양한 유형의 쿼리를 비용 최적화된 모델로 라우팅하여 운영 효율성 극대화

2. 멀티테넌트 플랫폼

각기 다른 고객 요구사항에 맞춘 전문화된 라우팅 서비스 제공

3. 개발 환경

다양한 워크로드에서 비용과 성능의 최적 균형점 달성

4. 프로덕션 서비스

내장된 안전장치와 함께 최적의 모델 선택 보장

차세대 AI 인프라의 미래

새로운 트렌드들

- 학습 기반 라우팅: 성능 피드백을 바탕으로 자가 개선하는 라우터

- 멀티모달 MoM: 텍스트, 이미지, 오디오, 비디오 모델 간 라우팅

- 연합 MoM: 분산된 프라이빗 모델 배포 간 라우팅

- 실시간 최적화: 현재 모델 성능과 비용에 기반한 동적 라우팅

차세대 기능들

- 예측적 라우팅: 사용자 니즈 예측 및 적절한 모델 사전 로드

- 품질 인식 라우팅: 실시간 품질 모니터링과 자동 장애 조치

- 비용 인식 스케줄링: 현재 가격과 예산 제약 기반 라우팅

- 사용자 선호 학습: 개별 사용자 패턴 기반 개인화된 라우팅

결론

vLLM Semantic Router가 제시하는 Mixture-of-Models 접근법은 단순한 비용 최적화 전략을 넘어서, AI 시스템 배포와 확장에 대한 근본적인 재개념화를 의미합니다.

핵심 가치:

- 비용: 품질을 유지하거나 향상시키면서 50-80% 비용 절감

- 성능: 전문화된 모델 선택을 통한 성능 향상

- 신뢰성: 분산된, 장애 허용 아키텍처로 안정성 증대

- 혁신: 유연하고 확장 가능한 라우팅 시스템으로 혁신 가능

프로덕션 배포 사례들이 보여주는 증거는 명확합니다. MoM은 단순히 LLM 배포의 미래가 아니라, AI를 책임감 있고 비용 효율적으로 확장하려는 조직들의 현재 현실입니다.

vLLM Semantic Router는 모든 규모의 조직이 고품질 AI 서비스를 경제적으로 제공할 수 있게 하는 핵심 인프라가 될 것입니다.

참고링크 :

https://github.com/vllm-project/semantic-router

https://vllm-semantic-router.com/

답글 남기기