AI 기술이 발전함에 따라 개인 정보 보호와 데이터 주권에 대한 관심이 높아지고 있습니다. 이러한 요구에 부응하여 등장한 LocalAI는 AI 모델을 로컬 환경에서 실행할 수 있게 해주는 오픈소스 솔루션입니다. LLM서비스가 필수이지만, 기업의 보안 측면을 위해 자체 LLM에대한 요구가 더 확고해지는것 같습니다. 다만, 자체 LLM을 위한 성능과 리소스의 최적화된 해결책은 아직 뚜렷하게 보이지는 않는것 같습니다. 완벽하게는 아니더라도 LocalAI가 이 부분의 해결을 위해 좀더 가까이 간 케이스라고 생각됩니다.

그래서, Local AI에 대한 이야기를 하려고 하는데, 이 대척점에 TGI가 있어, 오늘은 LocalAI의 특징과 TGI(Text Generation Inference)와의 차이점을 중심으로 살펴보겠습니다.

LocalAI란 무엇인가?

LocalAI는 AI 모델을 로컬에서 실행하기 위한 완전한 AI 스택입니다. 간단하고 효율적이며 접근하기 쉽게 설계되었으며, OpenAI API의 대체재 역할을 하면서도 데이터를 사용자의 기기 내에서만 처리하여 프라이버시를 보장합니다.

LocalAI의 핵심 가치

- 프라이버시 우선: 데이터가 사용자의 기기를 벗어나지 않습니다

- 완전한 제어: 사용자의 조건과 하드웨어로 모델을 실행할 수 있습니다

- 오픈소스: MIT 라이선스로 제공되며 커뮤니티 중심으로 발전합니다

- 유연한 배포: 노트북부터 서버까지, GPU 유무에 관계없이 사용 가능합니다

- 확장성: 필요에 따라 새로운 모델과 기능을 추가할 수 있습니다

LocalAI vs TGI: 주요 차이점

TGI(Text Generation Inference)와 LocalAI는 대규모 언어 모델(LLM)을 활용하는 방식을 혁신하는 두 가지 핵심 오픈소스 도구입니다. 하지만 두 솔루션은 지향하는 목표와 기술적 접근 방식에서 뚜렷한 차이를 보입니다. TGI는 고성능, 대규모 추론에 최적화된 서빙 솔루션인 반면, LocalAI는 개인화된 로컬 환경에서 다양한 AI 모델을 손쉽게 실행하는 데 중점을 둡니다.

TGI는 고속도로를 달리는 스포츠카와 같습니다. 압도적인 속도와 성능으로 대량의 텍스트 생성 요청을 처리하는 데 특화되어 있습니다. 반면, LocalAI는 모든 종류의 도구를 싣고 어디든 갈 수 있는 만능 트럭에 비유할 수 있습니다. CPU만 있는 비포장도로부터 GPU가 있는 고속도로까지 다양한 환경에서 텍스트, 이미지, 오디오 등 여러 화물을 실어 나를 수 있는 유연성과 범용성을 자랑합니다.

어떤 도구를 선택해야 할지는 사용자의 구체적인 목표, 즉 처리량과 속도가 중요한지, 아니면 개인정보 보호와 다양한 모델 활용성이 중요한지에 따라 달라집니다.

방향성 및 목표

- TGI (Text Generation Inference): 허깅페이스(Hugging Face)가 개발한 TGI는 LLM을 프로덕션 환경에서 효율적으로 배포하고 서빙하는 것을 최우선 목표로 합니다. 대규모 요청을 빠르고 안정적으로 처리하기 위한 다양한 최적화 기술이 집약된, 고성능 추론 서버에 가깝습니다.

- LocalAI: 이름에서 알 수 있듯이 ‘로컬 우선(Local-first)‘을 핵심 철학으로 삼습니다. OpenAI API와 호환되는 인터페이스를 제공하여, 사용자가 자신의 컴퓨터에서 데이터를 외부에 노출하지 않고 안전하게 LLM을 비롯한 다양한 AI 모델을 실행할 수 있도록 지원합니다. 단순한 텍스트 생성을 넘어 이미지, 오디오 생성 등 다재다능한 로컬 AI 허브를 지향합니다.

주요 기능 및 성능 비교

| 특징 | TGI (Text Generation Inference) | LocalAI |

| 주요 초점 | 고성능, 고처리량 텍스트 생성 추론 | 로컬 우선, 개인정보 보호, 다목적 AI 실행 |

| 핵심 기술 | – 연속 배치(Continuous Batching): 요청을 동적으로 묶어 처리 효율 극대화 – PagedAttention: 메모리 관리 최적화 – FlashAttention: 어텐션 계산 속도 향상 – 텐서 병렬화(Tensor Parallelism): 여러 GPU에 모델 분산 | – 다양한 백엔드 지원: llama.cpp, vLLM, transformers 등<br>- OpenAI API 호환성: 기존 OpenAI 연동 코드를 거의 그대로 사용– 다중 모달리티(Multi-modality): 텍스트, 이미지, 오디오, 임베딩 등 지원 – GPU 선택적 사용: GPU 없이 CPU만으로도 구동 가능 |

| 성능 | 매우 높음. 프로덕션 레벨의 대규모 트래픽 처리에 최적화되어 지연 시간이 짧고 처리량이 높습니다. | 유연함. 사용하는 백엔드와 하드웨어에 따라 성능이 크게 달라집니다. vLLM 백엔드를 사용하면 TGI에 근접하는 성능을 낼 수도 있지만, CPU 환경에서는 속도가 느릴 수 있습니다. |

| API | OpenAI 호환 API 및 세부 제어가 가능한 자체 generate 엔드포인트 제공 | OpenAI API의 ‘드롭-인 대체재(drop-in replacement)’를 표방하며 높은 호환성을 갖고 있습니다. |

하드웨어 요구사항 및 모델 지원

- 하드웨어:

- TGI: 강력한 NVIDIA GPU 사용을 적극 권장하며, 최상의 성능을 위해 H100, A100과 같은 데이터센터급 GPU 환경에서 주로 사용됩니다. GPU 없이는 사실상 사용이 어렵습니다.

- LocalAI: CPU만 있는 일반 소비자용 컴퓨터에서도 실행 가능합니다. 물론 NVIDIA, AMD, Intel GPU가 있는 경우 이를 활용하여 성능을 크게 향상시킬 수 있습니다. 하드웨어 선택의 폭이 매우 넓습니다.

- 지원 모델:

- TGI: Llama, Mistral, Mixtral, Falcon, StarCoder 등 허깅페이스 허브의 인기 있는 최신 트랜스포머 기반 모델들을 공식적으로 지원하고 최적화합니다.

- LocalAI:

gguf포맷을 사용하는llama.cpp백엔드를 통해 매우 광범위한 모델을 지원합니다. 커뮤니티에서 양자화된 소규모 모델부터 대형 모델까지 사실상 거의 모든 오픈소스 LLM을 실행할 수 있습니다. 텍스트 생성 모델 외에 Stable Diffusion(이미지), Whisper(음성 인식) 등 다양한 모델을 지원하는 것이 큰 장점입니다.

어떤 것을 어떤 경우에 선택해야 할까?

TGI를 선택해야 하는 경우:

- 대규모 상용 서비스를 구축하여 수많은 사용자에게 LLM 기반 기능을 제공해야 할 때

- 최대한 낮은 지연 시간과 높은 처리량이 비즈니스 요구사항의 핵심일 때

- 허깅페이스 생태계의 최신 모델을 최고의 성능으로 운영하고 싶을 때

- 강력한 GPU 서버 인프라를 이미 갖추고 있거나 구축할 계획이 있을 때

LocalAI를 선택해야 하는 경우:

- 개인 컴퓨터나 온프레미스(On-premise) 서버에서 AI 모델을 실행하고 싶을 때

- 데이터 프라이버시가 매우 중요하여 외부로 데이터를 전송하면 안 되는 경우

- 텍스트 생성뿐만 아니라 이미지 생성, 음성-텍스트 변환 등 다양한 AI 기능을 하나의 플랫폼에서 실험하고 싶을 때

- 강력한 GPU 없이 CPU 환경에서 AI 모델을 테스트하거나 가볍게 사용해보고 싶을 때

- 기존에 OpenAI API를 사용하던 프로젝트를 최소한의 코드 변경으로 로컬 환경으로 전환하고 싶을 때

- LocalAGI(자율 AI 에이전트), LocalRecall(시맨틱 검색) 등 다양한 구성 요소를 포함하는 완전한 AI 스택을 요구할 때

LocalAI의 핵심 구성 요소

LocalAI는 단일 도구가 아닌 완전한 생태계로 구성되어 있습니다:

1. LocalAI Core

- OpenAI 호환 API

- 다양한 모델 지원 (LLM, 이미지, 오디오)

- GPU 불필요

- 네이티브 바인딩을 통한 빠른 추론

2. LocalAGI

- 자율 AI 에이전트

- 코딩 불필요

- WebUI 및 REST API 지원

- 확장 가능한 에이전트 프레임워크

3. LocalRecall

- RAG

- 시맨틱 검색

- 메모리 관리

- 벡터 데이터베이스

- AI 애플리케이션에 최적화

LocalAI 시작하기

LocalAI를 시작하는 가장 빠른 방법은 원라인 인스톨러를 사용하는 것입니다:

curl https://localai.io/install.sh | sh또는 Docker를 사용하여 빠르게 시작할 수 있습니다:

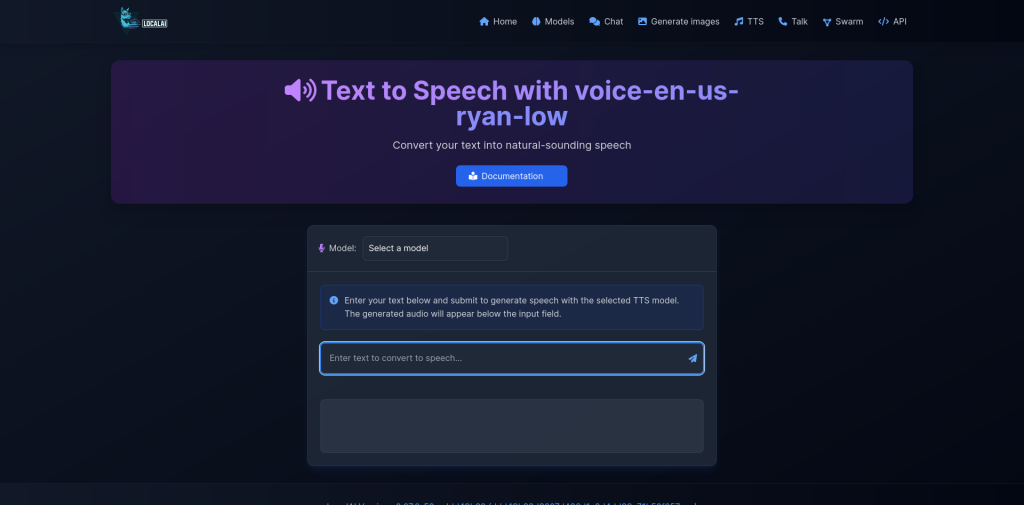

docker run -p 8080:8080 --name local-ai -ti localai/localai:latest-aio-cpuLocalAI의 주요 기능

- 텍스트 생성: 다양한 LLM을 로컬에서 실행

- 이미지 생성: Stable Diffusion을 통한 이미지 생성

- 오디오 처리: 텍스트-음성 변환 및 음성-텍스트 변환

- 비전 API: 이미지 이해 및 분석

- 임베딩: 벡터 데이터베이스 지원

- 함수: OpenAI 호환 함수 호출

- P2P: 분산 추론 기능

결론

LocalAI는 프라이버시를 중시하면서도 강력한 AI 기능을 활용하고자 하는 개발자와 기업에게 이상적인 솔루션입니다. OpenAI API와의 호환성, 다양한 모델 지원, GPU 없이도 작동하는 유연성은 TGI와 같은 다른 솔루션과 차별화되는 강점입니다.

특히 데이터 주권과 프라이버시가 중요한 프로젝트에서 LocalAI는 클라우드 기반 AI 서비스의 강력한 대안이 될 수 있습니다. MIT 라이선스로 제공되는 오픈소스 프로젝트이므로 커뮤니티의 지원을 받으며 계속 발전하고 있습니다.

답글 남기기