[카테고리:] AI

-

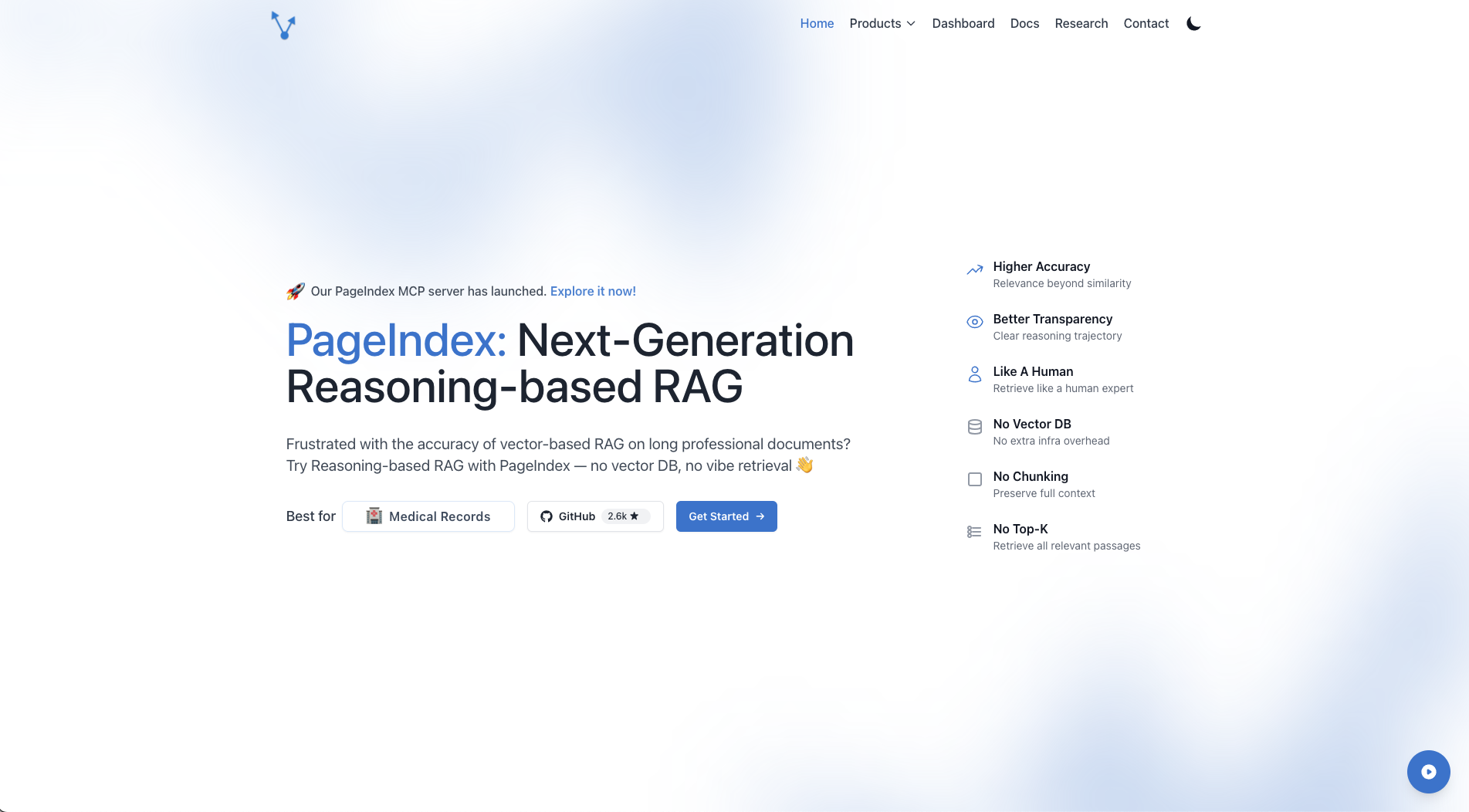

PageIndex: 벡터 없는 혁신적인 RAG 서비스 소개

인공지능 시대에 문서 검색과 정보 추출은 비즈니스의 핵심 요소가 되었습니다. 그동안 RAG(Retrieval-Augmented Generation) 시스템은 벡터 데이터베이스를 기반으로 한 유사도 검색에 의존해왔지만, 유사도가 곧 관련성을 의미하지는 않는다는 근본적인 한계가 있었습니다. 여기 이러한 문제를 다른 식으로 해석하여 풀어낸 케이스가 있어 소개합니다. PageIndex는 전통적인 벡터 기반 RAG와는 완전히 다른 접근법을 제시합니다. AlphaGo에서 영감을 받은 이 혁신적인 서비스는 인간…

-

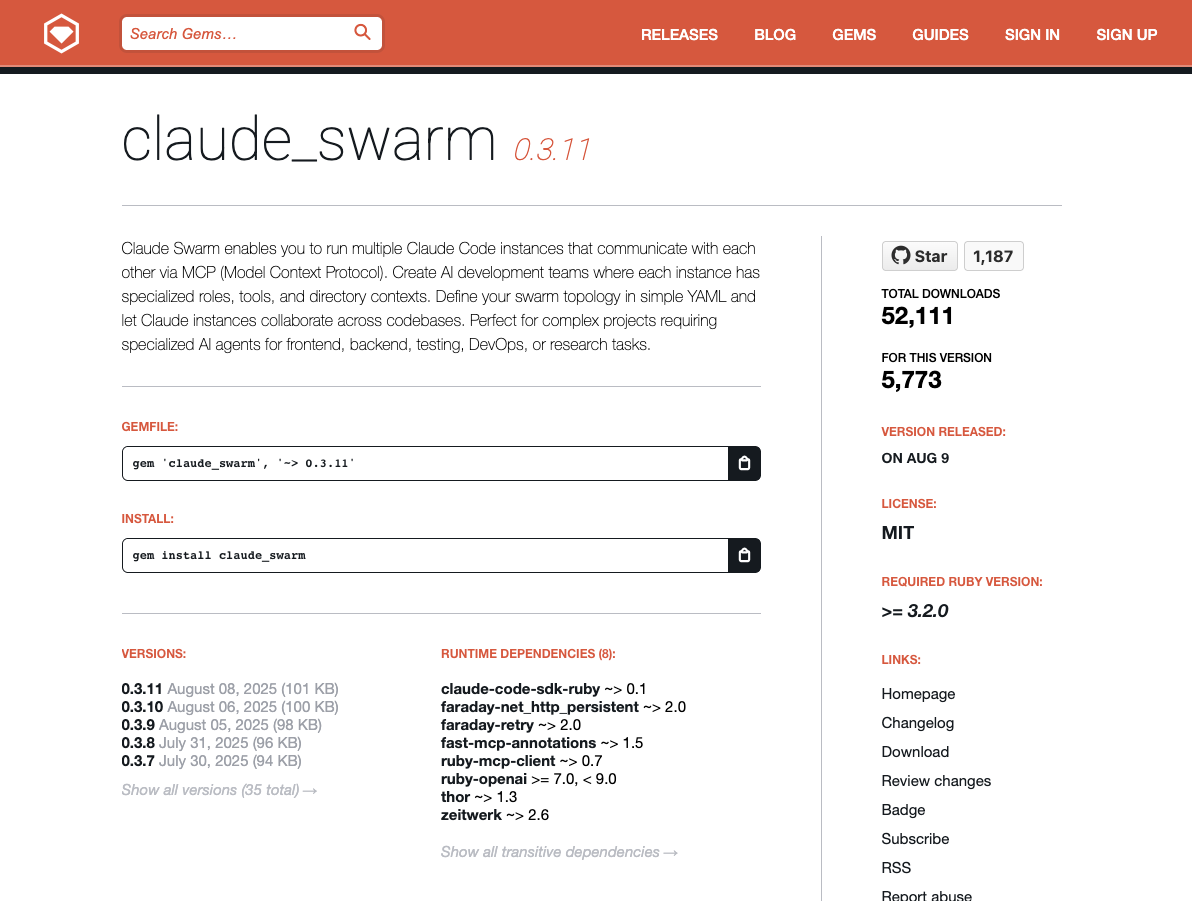

Claude Swarm: AI 개발팀 오케스트레이션 도구의 모든 것

현대 소프트웨어 개발은 점점 더 복잡해지고 있습니다. 프론트엔드, 백엔드, 데이터베이스, DevOps 등 다양한 전문 영역이 존재하며, 각 영역마다 고유한 지식과 도구가 필요합니다. Claude Swarm은 이러한 복잡성을 해결하기 위해 등장한 혁신적인 도구로, 여러 Claude Code 인스턴스를 협업하는 AI 개발팀으로 오케스트레이션합니다. 이 글에서는 Claude Swarm의 기능, 설치 방법, 구성 방법, 실제 사용 사례 및 개발 업계에서의 활용…

-

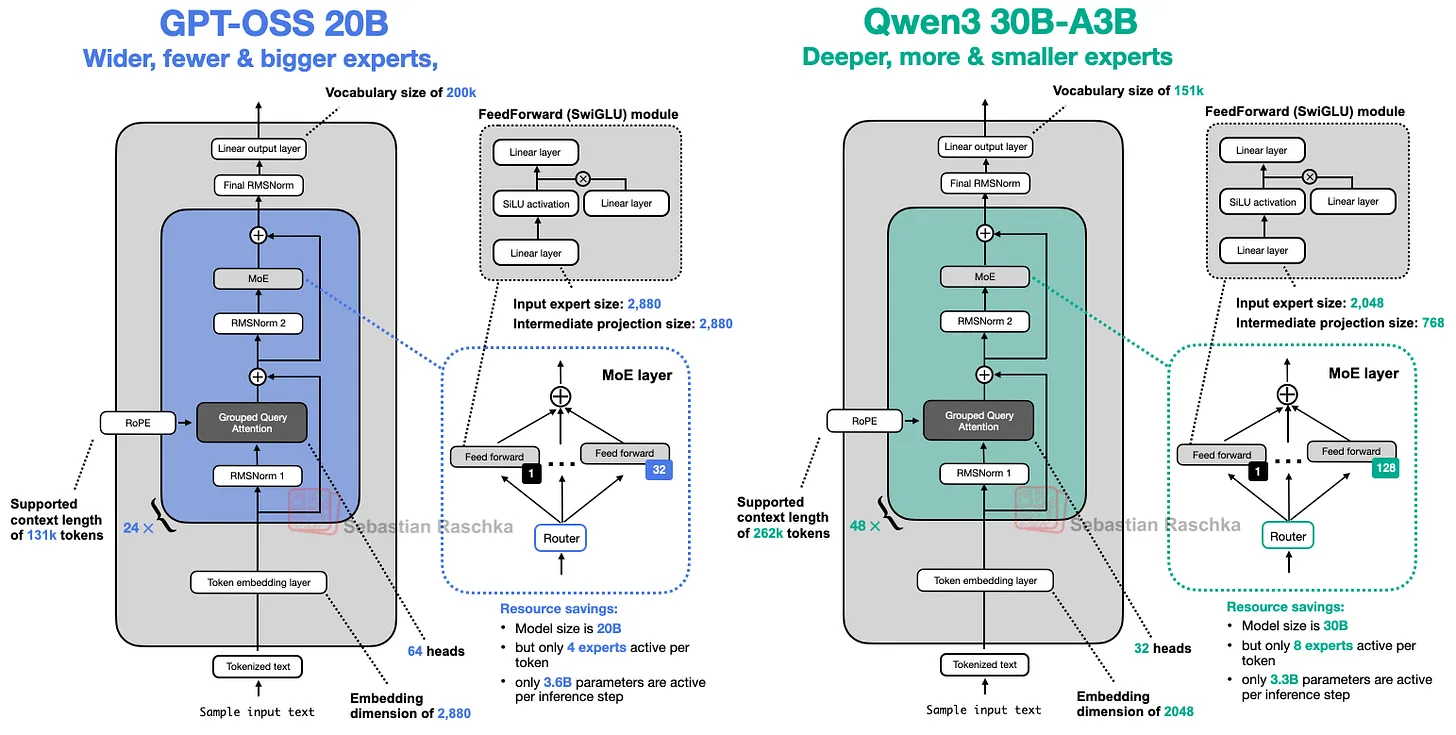

GPT-2에서 GPT-OSS까지: AI 아키텍처의 진화와 Qwen3와의 비교

2025년 8월, OpenAI는 GPT-2 이후 6년 만에 다시 오픈 웨이트 모델을 공개했습니다. GPT-OSS-20B와 GPT-OSS-120B 모델은 단순히 크기만 큰 것이 아니라, 지난 몇 년간 축적된 트랜스포머 아키텍처의 혁신들을 집약한 결과물입니다. 이번 글에서는 GPT-2부터 GPT-OSS까지의 아키텍처 변화 과정을 살펴보고, 특히 현재 최고 성능을 자랑하는 오픈 웨이트 모델 중 하나인 Qwen3와의 비교하여 어떤 차이가 있는지에 대해서 잘 정리된…

-

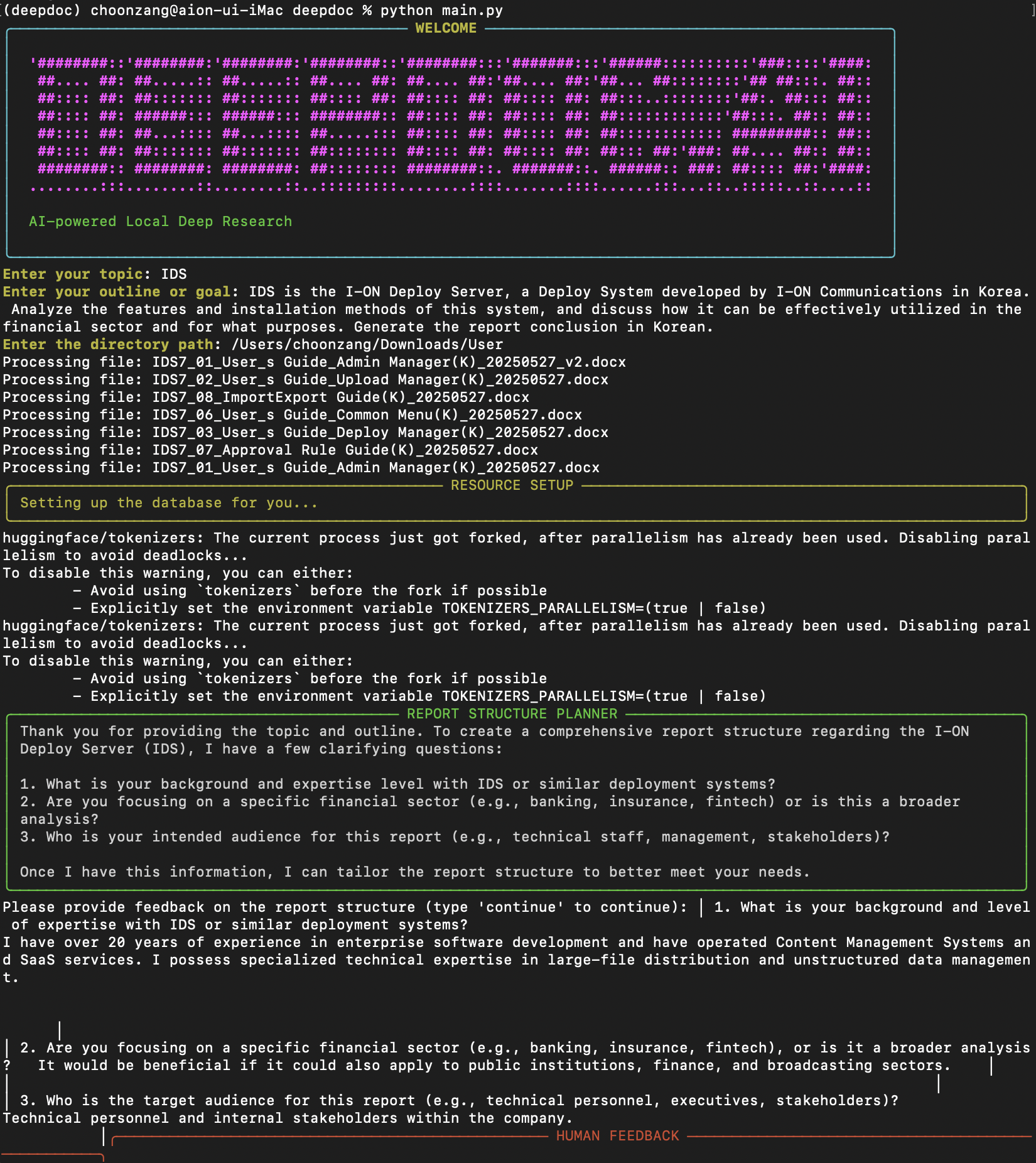

DeepDoc: 로컬 문서를 위한 강력한 리서치 도구

오늘날 정보의 홍수 속에서 자신이 보유한 문서들로부터 인사이트를 도출하는 것은 쉽지 않은 일입니다. 특히 방대한 양의 PDF, 워드 문서, 텍스트 파일 등을 일일이 검토하는 것은 시간과 노력이 많이 소요됩니다. 이런 문제를 해결하기 위해 등장한 DeepDoc은 로컬 문서에 대한 심층 분석을 자동화하는 혁신적인 도구입니다. DeepDoc이란 무엇인가? DeepDoc은 인터넷 검색 대신 사용자의 로컬 리소스를 깊이 있게 분석하는…

-

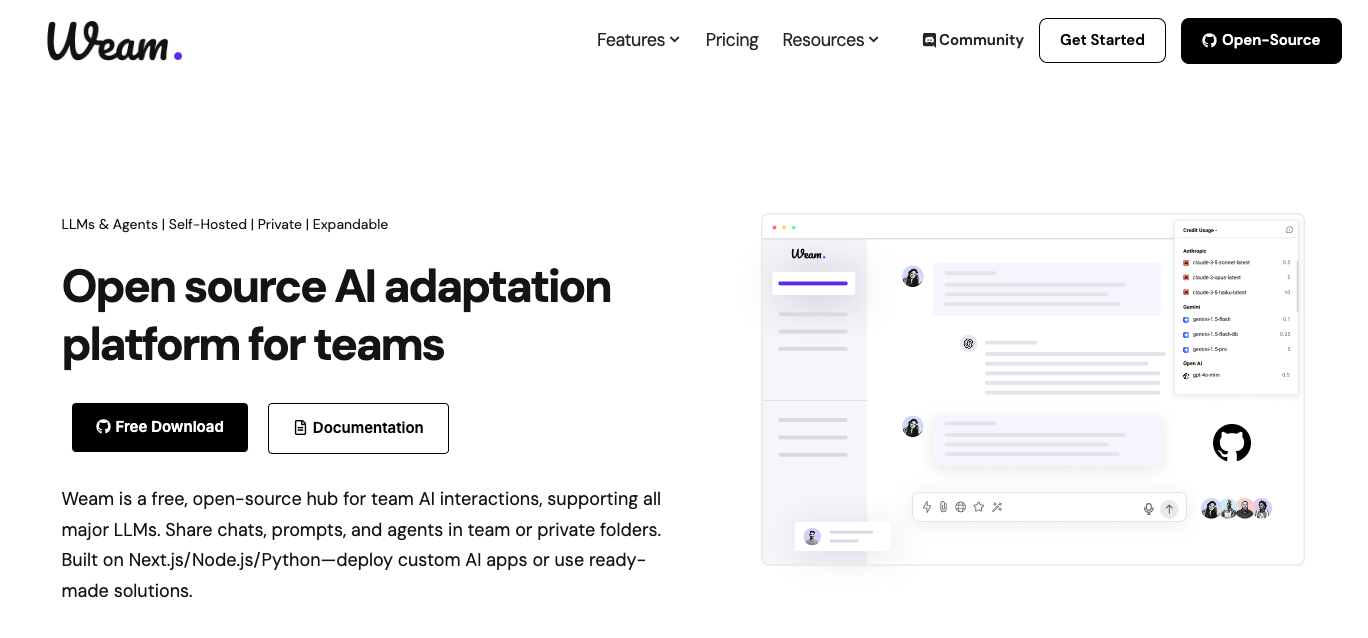

Weam AI Platform: 팀을 위한 협업형 AI 플랫폼 완벽 가이드

AI 기술이 급속도로 발전하면서 많은 팀과 기업들이 업무에 AI를 도입하고자 하지만, 어디서부터 시작해야 할지, 어떤 도구를 선택해야 할지 막막함을 느끼고 있습니다. 이런 상황에서 Weam AI는 팀을 위한 협업형 AI 플랫폼으로 주목받고 있습니다. 이 글에서는 Weam AI Platform의 개요부터 설치, 설정, 사용법까지 자세히 알아보겠습니다. Weam AI Platform 개요 Weam AI란? Weam AI는 디지털 에이전시, SaaS 스타트업,…

-

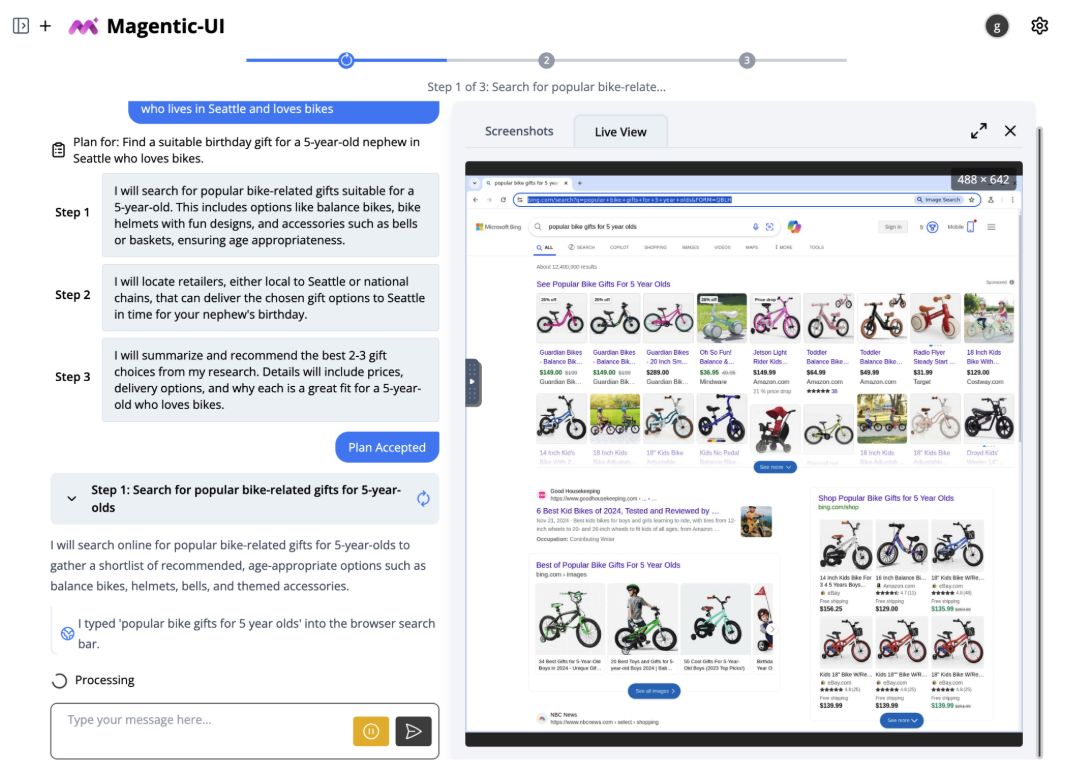

Magentic-UI: 웹 기반 작업을 위한 혁신적인 인간 중심 AI 에이전트

현대의 생산성은 웹을 기반으로 합니다. 정보 검색, 양식 작성, 대시보드 탐색 등 많은 작업이 웹에서 이루어집니다. 그러나 이러한 작업들은 여전히 수동적이고 반복적인 경우가 많습니다. 이러한 문제를 해결하기 위해 마이크로소프트에서 새로운 오픈소스 연구 프로토타입인 ‘Magentic-UI’를 소개합니다. Magentic-UI는 인간 중심 에이전트로서, 연구자들이 human-in-the-loop 접근 방식과 AI 에이전트의 감독 메커니즘에 관한 열린 질문을 연구하는 데 도움을 주기 위해…

-

AutoGEN: 다중 에이전트 AI 시대의 강력한 플레이어

인공지능의 진화는 우리가 상상했던 것보다 빠르게 진행되고 있습니다. 단일 AI 모델의 한계를 뛰어넘어, 이제는 여러 AI 에이전트가 협업하며 복잡한 문제를 해결하는 시대가 도래했습니다. 이러한 변화의 중심에 있는 것이 바로 Microsoft의 AutoGEN입니다. AutoGEN은 여러 AI 에이전트가 마치 인간 팀처럼 협력하여 문제를 해결할 수 있는 혁신적인 플랫폼입니다. 마치 각각의 전문가가 모여 팀을 이루어 복잡한 프로젝트를 완성하는 것처럼,…

-

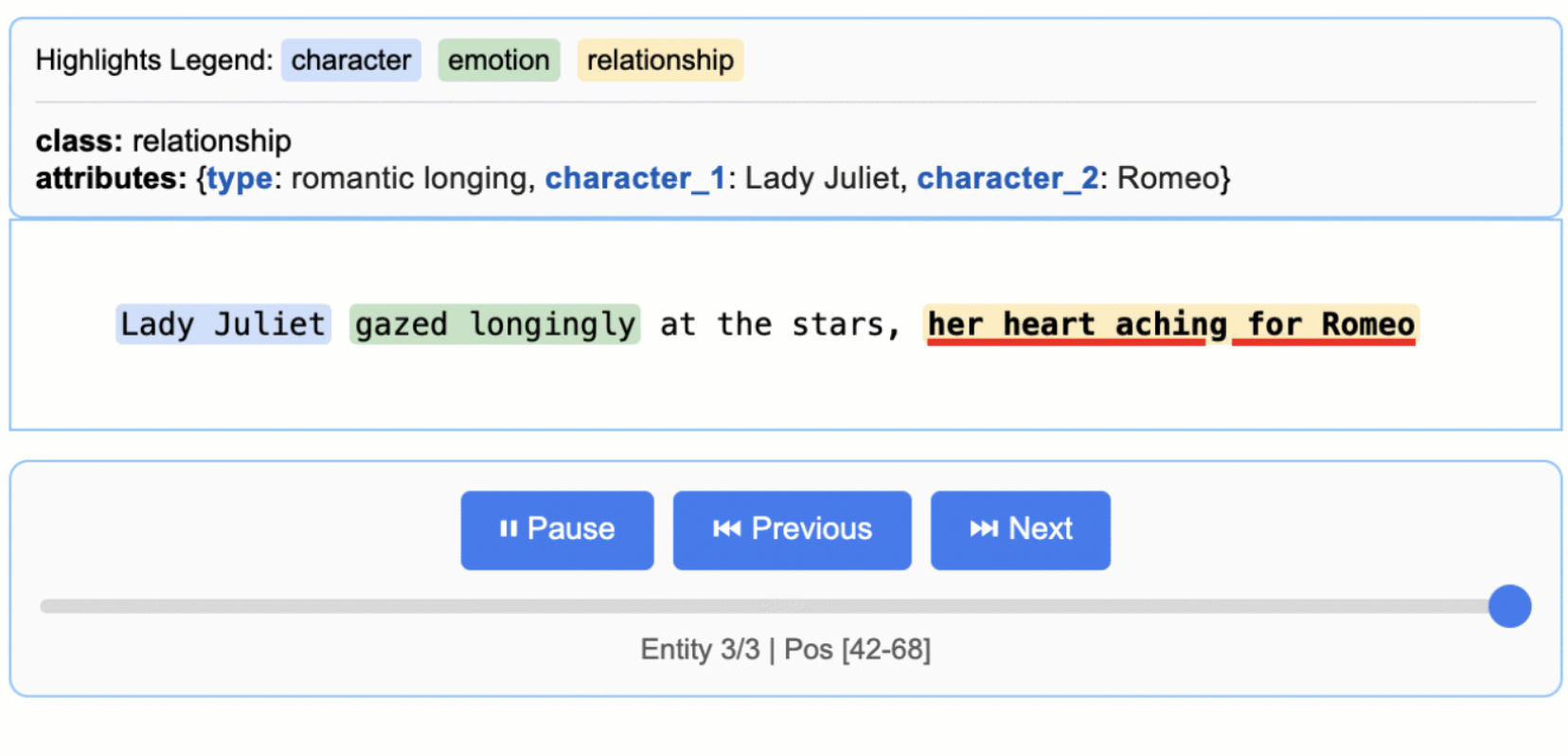

LangExtract: 구글이 공개한 Gemini 기반 정보 추출 라이브러리

비구조화된 텍스트에서 구조화된 정보를 추출하는 것은 오랫동안 자연어 처리의 핵심 과제 중 하나였습니다. 의료 기록, 법적 문서, 고객 피드백 등에 숨겨진 가치 있는 정보들을 정확하고 추적 가능한 형태로 추출하는 것은 여전히 기술적으로나 실무적으로 큰 도전이었습니다. 구글이 최근 공개한 LangExtract는 이러한 문제를 해결하기 위한 혁신적인 오픈소스 Python 라이브러리입니다. LangExtract란 무엇인가? LangExtract는 Gemini와 같은 대규모 언어 모델(LLM)을…