[카테고리:] IT

-

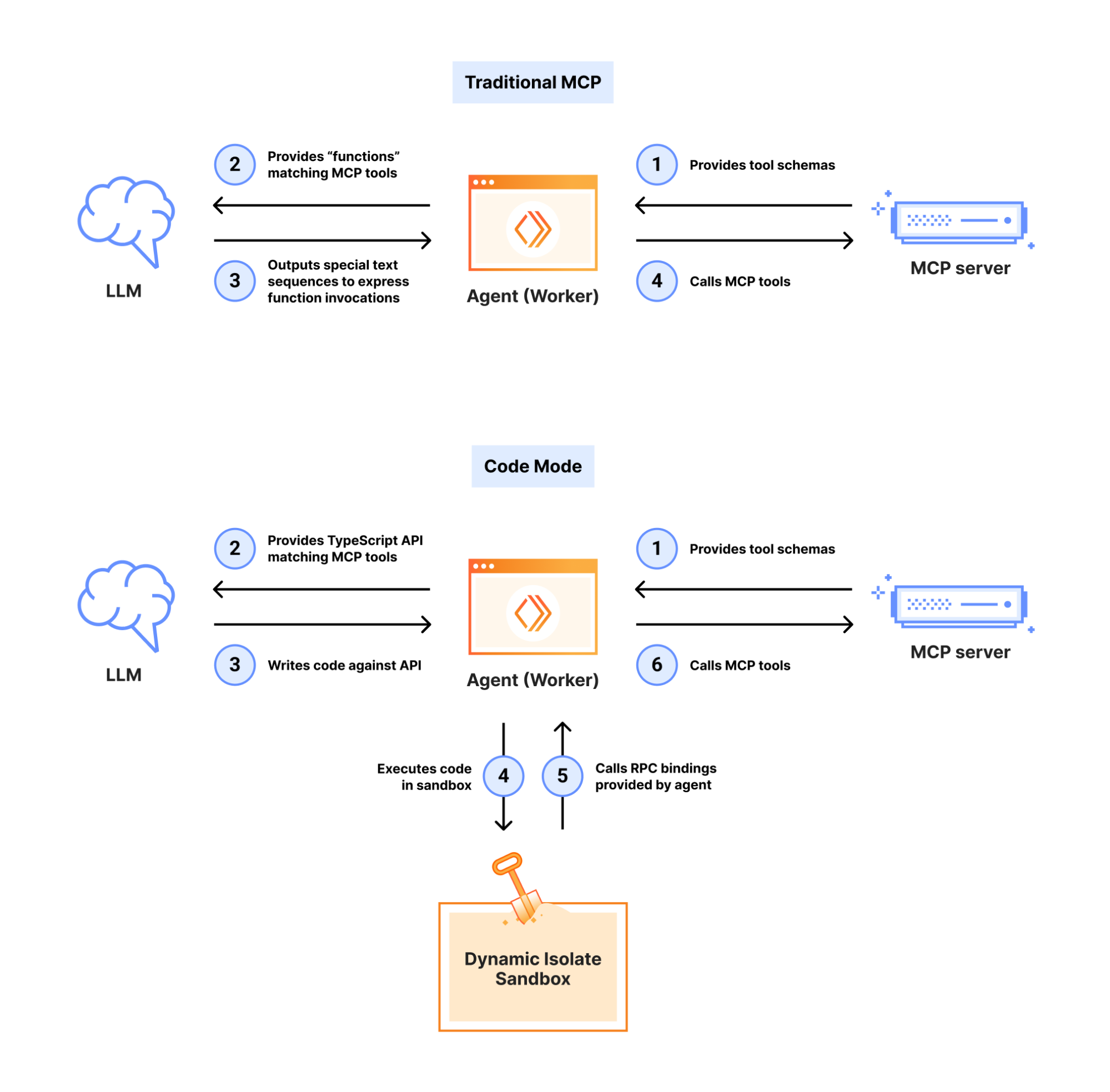

MCP Server와 코드 실행: AI 에이전트의 토큰을 98% 절감하는 방법

Model Context Protocol(MCP)은 AI 에이전트를 외부 시스템에 연결하는 표준 프로토콜로, 2024년 11월 출시 이후 빠르게 업계 표준으로 자리잡았습니다. 커뮤니티에서는 수천 개의 MCP 서버를 개발했고, 모든 주요 프로그래밍 언어용 SDK가 제공되고 있습니다. 하지만 연결되는 도구가 늘어날수록 예상치 못한 문제가 발생했습니다. 도구가 많아질수록 에이전트가 느려지고, 비용이 급격히 증가하는 것입니다. Anthropic은 최근 이 문제에 대한 혁신적인 해결책을 제시했습니다.…

-

가트너가 제시한 2026년 주목해야 할 10대 기술 트렌드

왜 가트너의 기술 트렌드에 주목해야 하는가? 매년 가트너(Gartner)가 발표하는 전략적 기술 트렌드는 단순한 예측이 아닙니다. 이는 전 세계 IT 기업들이 향후 비즈니스 방향과 전략을 설정하는 나침반과 같은 역할을 합니다. 글로벌 선도 기업들은 이 트렌드를 기반으로 투자 우선순위를 결정하고, 혁신의 방향을 설정하며, 조직의 디지털 전환 로드맵을 수립합니다. 따라서 IT 업계 종사자뿐만 아니라 비즈니스 리더라면 반드시 관심…

-

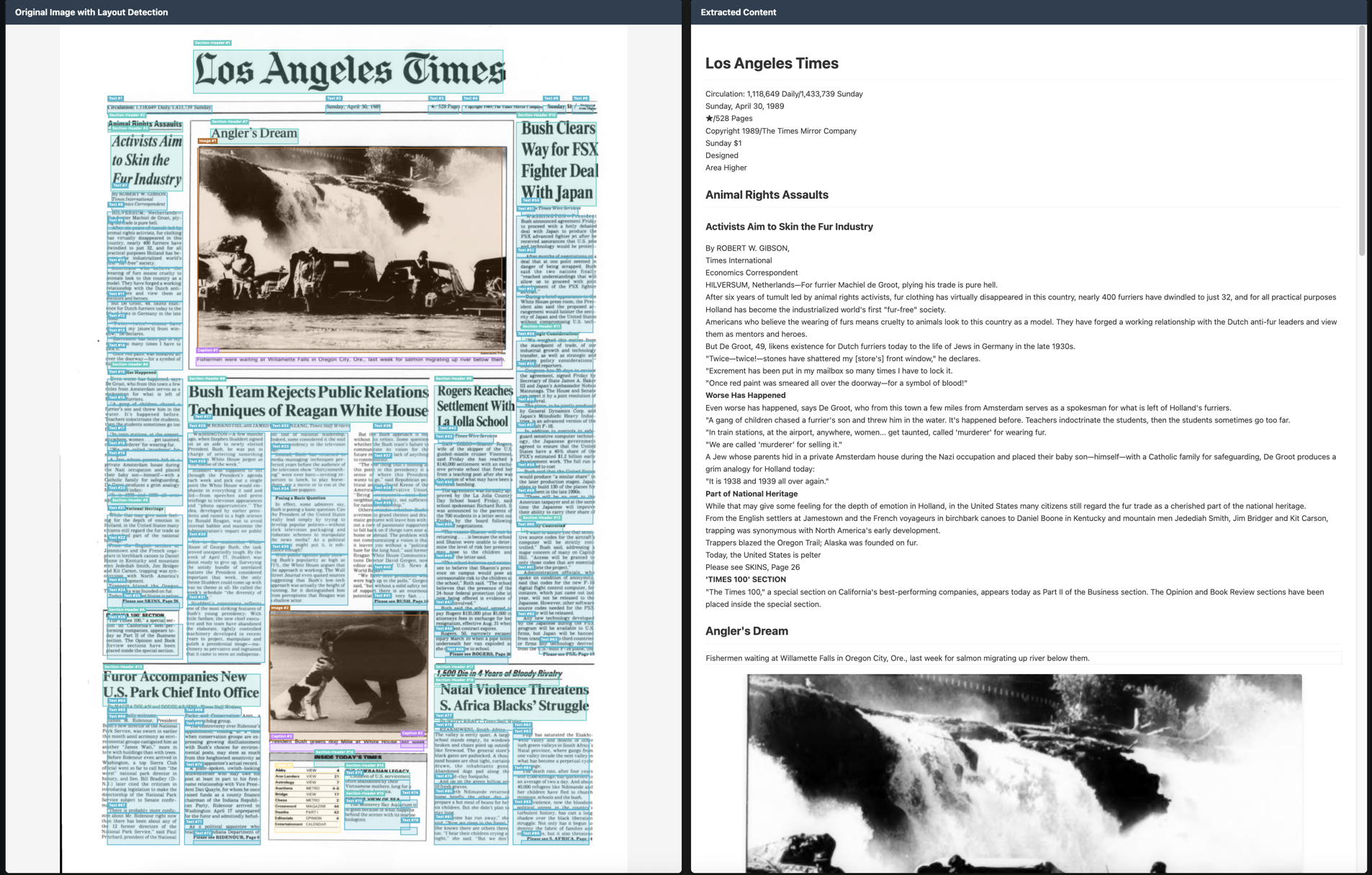

PaddleOCR: 산업 선도적인 OCR 및 문서 AI 엔진 완벽 가이드

문서와 이미지를 구조화된 AI 친화적 데이터로 변환하는 최첨단 솔루션인 PaddleOCR를 소개합니다. 텍스트 추출부터 지능형 문서 이해까지 엔드투엔드 솔루션을 제공하는 이 도구는 개인 개발자부터 대기업까지 전 세계적으로 AI 애플리케이션을 지원하고 있습니다. PaddleOCR의 핵심 가치 PaddleOCR는 문서와 이미지를 JSON, Markdown과 같은 구조화된 AI 친화적 데이터로 업계 최고의 정확도로 변환합니다. 5만 개 이상의 GitHub 스타를 보유하고 MinerU, RAGFlow,…

-

Agentic Context Engine (ACE): AI 에이전트의 자가 학습 혁명

인공지능 분야에서 가장 큰 도전 중 하나는 AI 에이전트가 같은 실수를 반복한다는 점입니다. 하지만 이제 그 문제를 해결할 수 있는 혁신적인 프레임워크가 등장했습니다. 바로 Agentic Context Engine(ACE)입니다. ACE는 AI 에이전트가 자신의 성공과 실패로부터 학습하여 지속적으로 개선될 수 있게 해주는 획기적인 도구입니다. 이 블로그 포스트에서는 ACE의 주요 기능, 작동 방식, 그리고 이를 활용하여 어떻게 더 스마트한…

-

Chandra: 레이아웃 보존 기능을 갖춘 고정밀 OCR 모델 소개

AI산업에서 문서의 디지털화는 이제 필수 입니다. 특히 OCR영역은 그 정확도를 다투는 매루 치열한 영역이며, 최근 공개된 이 모델도 더 높은 벤치마크 성능을 자랑하며 새롭게 등장한 OCR모델입니다. 오늘은 그 최신 OCR 모델인 Chandra에 대해 자세히 알아보겠습니다. Chandra는 Datalab에서 개발된 AI OCR모델로, 이미지와 PDF를 구조화된 HTML, Markdown, JSON으로 변환하면서 레이아웃 정보까지 완벽하게 보존하는 고정밀 OCR 모델입니다. Chandra의…

-

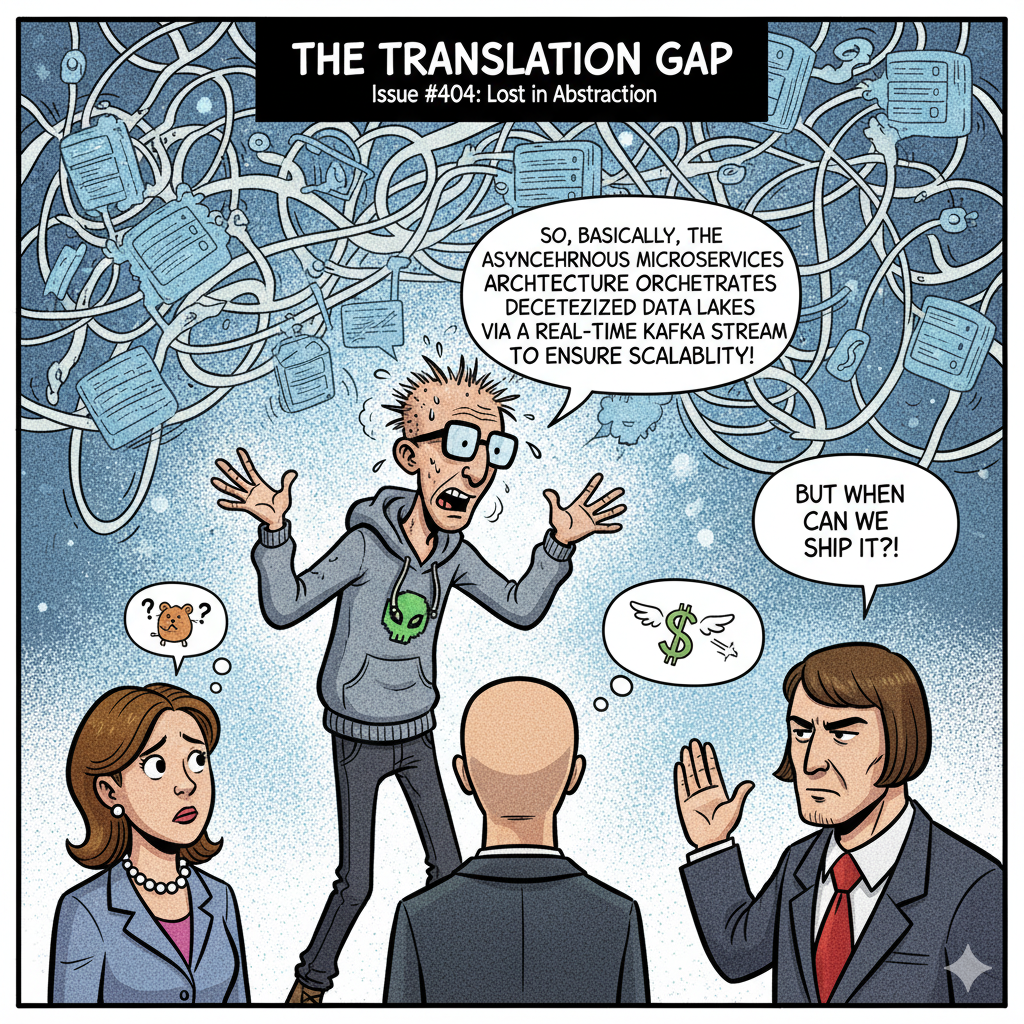

비기술 리더에게 기술적 명확성을 제공하는 방법

커뮤니티의 새로운 소식들을 찾아다니다가 호주의 한 소프트웨어 엔지니어의 블로그 포스트에 쓴 글이 매우 공감되어 포스트에 번역하여 옮겨보았습니다. 소프트웨어 비즈니스에서 어떤 이슈를 결정하는데 있어서 개발 기반이 아닌 결정권자들과 흔히 격는 상황에 대해서 솔직하게 이야기하고 있습니다. 그 사이에 매우 보수적인 또는 진보적인 개발자들 간에 리더에게 의사전달을 하는 방식의 차이도 한국의 상황과 크게 다르지 않아 공감이 되는 부분이…

-

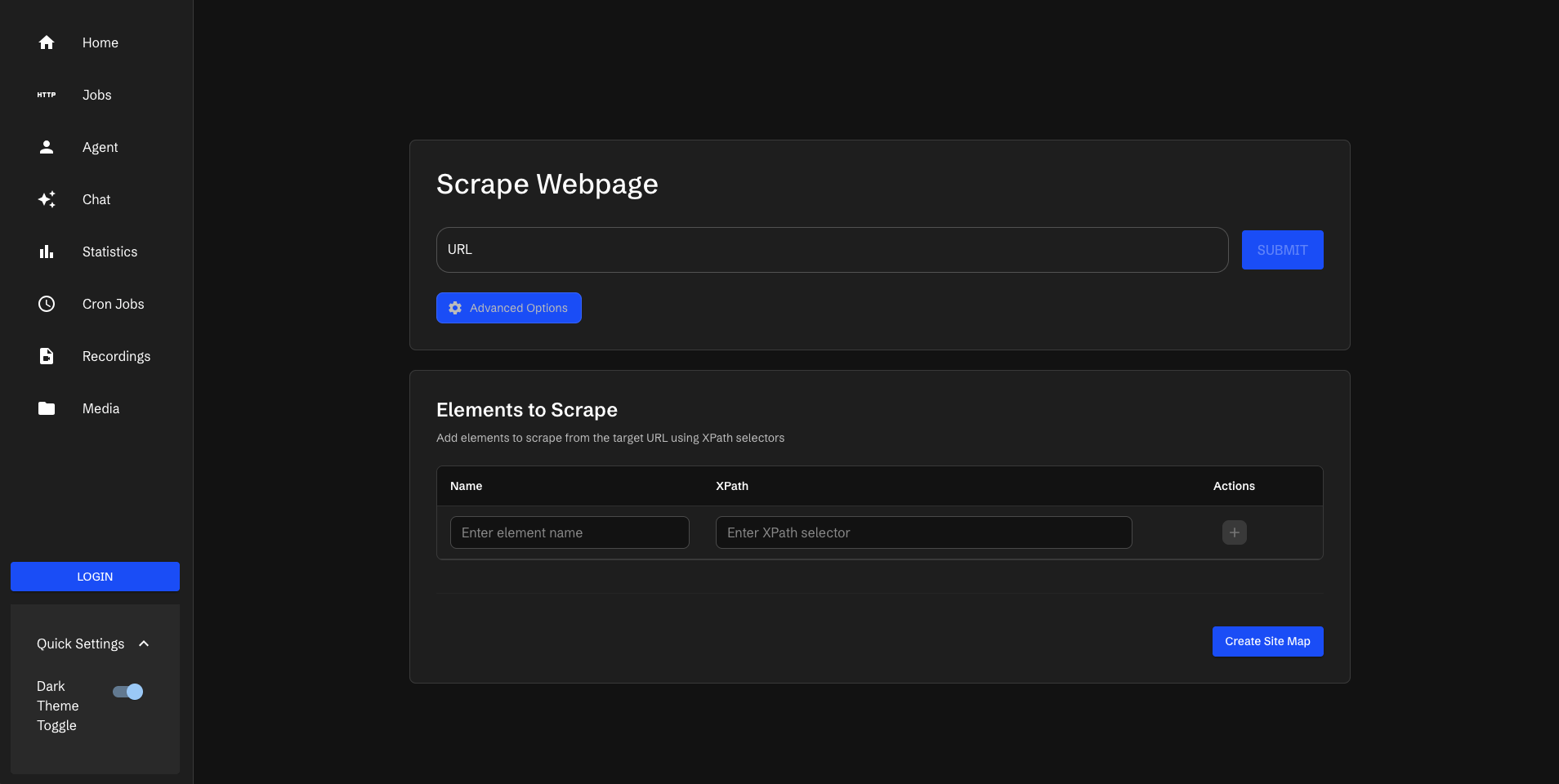

코드 한 줄 없이 웹 스크래핑하기: Scraperr 완벽 가이드

웹 스크래핑은 데이터 분석, 마케팅 리서치, 가격 모니터링 등 다양한 분야에서 필수적인 작업입니다. 때문에 요즘 오픈소스 스크래퍼 또는 크롤링 도구들이 많이 요구 됩니다. 오늘 소개할 어플리케이션도 이 웹스크래핑을 위한 셀프호스트 기반의 웹스크래퍼 인 Scraperr에 대한 포스트를 하려고 합니다. RAG 시스템에 웹사이트의 컨텐츠를 Ingest하기 위해서는 웹사이트의 데이터 스크래핑이 반드시 요구 됩니다. 그 과정에서 여러 크롤러 또는…

-

Mistral OCR: 높은 정확도의 문서 인식 기술

디지털 전환 시대를 맞아 기업들은 방대한 양의 문서를 효율적으로 처리해야 하는 과제에 직면해 있습니다. 전 세계 조직 데이터의 약 90%가 여전히 문서 형태로 저장되어 있다는 사실은 문서 인식 기술의 중요성을 단적으로 보여줍니다. 2025년, 3월 6일, Mistral AI가 공개한 Mistral OCR은 이러한 문서 처리 영역에서 획기적인 도약을 이뤄냈습니다. 이미 6개월 이상이 지난 지금(2025.10)에서도 OCR과 관련된 모델에…

-

![[Nuxt.js-12] Nuxt.js 미들웨어(Middleware)와 라우트 가드](https://blog.choonzang.com/wp-content/uploads/2025/09/nuxt-12.png)

[Nuxt.js-12] Nuxt.js 미들웨어(Middleware)와 라우트 가드

안녕하세요! Nuxt.js 시리즈의 12번째 포스팅입니다.. 지난 번에는 플러그인과 유틸리티에 대해 알아보았는데요, 이번 시간에는 Nuxt.js의 강력한 기능 중 하나인 미들웨어(Middleware)와 라우트 가드에 대해 자세히 알아보겠습니다. 미들웨어는 페이지나 레이아웃이 렌더링되기 전에 실행되는 함수로, 사용자 인증 확인, 데이터 사전 로드, 리다이렉션 처리 등 다양한 상황에서 활용할 수 있습니다. 이를 통해 더 안전하고 유연한 애플리케이션을 구축할 수 있습니다. 1.…